Cloud Computing - aber sicher!

Auch Mittelständler und öffentliche Einrichtungen beschäftigen sich zunehmend mit Cloud-Diensten. Damit dies in keinem Desaster endet, das morgen in der Zeitung steht, gilt es einige Punkte zu beachten. Als erstes sollte die Frage gestellt werden, welche Anwendungen prädestiniert sind, in eine Cloud ausgelagert zu werden.

Anwendungsfälle

Diese haben sich als besonders geeignet erwiesen:

- dynamische Webapplikationen und DevOps-Anwendungen

- temporäre Umgebungen für Test und Entwicklung, zeitlich begrenzte Projekte oder Lastspitzen

- Nutzung der Netzwerkressourcen großer Anbieter für ein optimales Peering oder Auslieferung von digitalen Inhalten

- Vorhalten von Off-Site-Backups und Desaster-Recovery-Ressourcen

- Auslagerung von Applikationen

Die Abrechnung erfolgt nach tatsächlicher Nutzung der Ressourcen. Werden Umgebungen längerfristig benötigt, können Ressourcen auch dediziert angemietet werden. Dies sorgt für niedrigere Kosten und bessere Planbarkeit, erhöht aber auch die Bindung an einen Anbieter. Klassische Systeme im 24×7-Betrieb innerhalb der Cloud rechnen sich jedoch in den wenigsten Fällen. Als Berechnungsgrundlage dienen meist verwendete Compute-Ressourcen, benötigter Speicherplatz und sowie Transfervolumen. Letzteres erschwert eine genaue Kostenkalkulation.

Cloud-IT-Services

Hierbei in folgende Kategorien unterteilt:

- Infrastructure as a Service (IaaS)

- Plattform as a Service (PaaS)

- Software as a Service (SaaS)

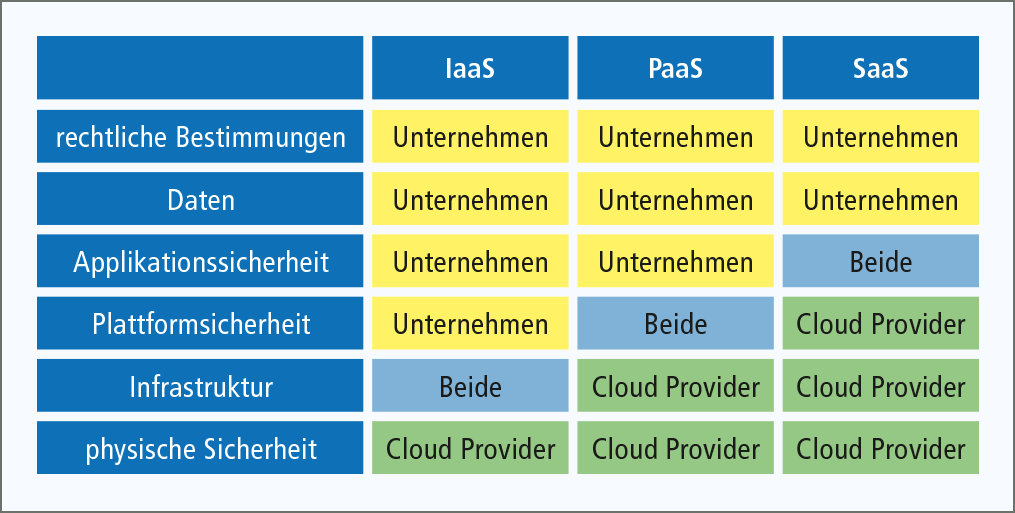

Je nach Kategorie hat der Kunde unterschiedliche Verantwortlichkeiten zum sicheren Betrieb der Dienste. Diese sind im sogenannten „shared responsibility model“ festgehalten und sind wie folgt definiert:

Generell gilt: Unternehmen sind für die Einhaltung von rechtlichen Bestimmungen und den Schutz ihrer Daten selbst verantwortlich. Aber auch das Berechtigungsmanagement und beim PaaS und IaaS das Patch- und Update-Management gehören zur Verantwortung eines jeden Kunden. Wichtig ist die Datensicherheit bereits bei der Planung zu berücksichtigen. Ist ein geeigneter Workload für einen Cloud-Dienst gefunden, so stellt sich meist die Frage nach der Authentifizierung der Benutzer. Zwar bieten die Cloud-Anbieter meist eigene Verzeichnisdienste sowie die Synchronisation mit diesen an, es empfiehlt sich jedoch die Authentifizierung gegen den eigenen Verzeichnisdienst. Hier hat sich der Active-Directory-Federation-Service als Quasi-Standard für Unternehmen etabliert. Die Authentifizierung des Benutzers erfolgt hierbei gegen den Verzeichnisdienst des Unternehmens. Lediglich die User-ID wird mit der Cloud synchronisiert. Passwort-Hashs und andere sensible Daten bleiben aber im Unternehmen.

Dieses Verfahren ist für mehrere Cloudanbieter universell einsetzbar. Zusätzlich ist diese Art der Authentifizierung mittels einer Multifaktorauthentifizierung erweiterbar. Dabei wird das Domainpasswort des Benutzers z.B. durch Wissen (z.B. Pin) und Besitz (Hardware- oder Softwaretoken) ersetzt. Damit ist die Identität des Benutzers zweifelsfrei feststellbar und eine Entwendung durch Dritte massiv erschwert. Die folgende Skizze zeigt den Einsatz am Beispiel von Office 365:

Doch welche Funktionen bieten große Cloud-Anbieter wie Amazon, Microsoft und Google an?

Generell können diese in folgende Kategorien eingeteilt werden:

- Compute

- Netzwerk

- Storage

- Webservices

- Identity & Access Management

- Backup und Desaster Recovery

- Key Management Services

Beim Bereich Compute handelt es sich um die Bereitstellung von Rechenressourcen in Form von virtuellen oder dedizierten Servern, den Betrieb von Containern und einen Zusammenschluss mehrerer Systeme mit automatischer Skalierung der Systemanzahl.

Für den Transport der Daten werden entsprechende Netzwerke bereitgestellt. Diese ermöglichen auch zusätzliche Dienste wie DNS, Gateways, Load Balancer, MPLS-Anbindungen und Content Delivery Netzwerke. Für die Speicherung wird ein entsprechender Storage benötigt. Hier stehen unterschiedlichste Dienste für unterschiedliche Einsatzszenarien zur Verfügung. Generell kann in Volume- und Objektstorage unterschieden werden. Für diese stehen unterschiedliche Preiskategorien zur Auswahl. Compute, Storage und Netzwerk vereinigen hierbei die Funktionen klassischer Infrastrukturen.

Für die Bereitstellung von Webservices werden jedoch meist PaaS-Angebote genutzt. Dabei stellt der Cloud-Anbieter die Umgebung bis hin zum Webserver zur Verfügung und betreibt diese. Der Kunde stellt entsprechende Applikationen auf dieser Basis bereit. So sind auch komplexere Frontend- und Backendszenarien möglich, sowie die Aufteilung in mehrere Worker-Rollen. Eine Integration mit gängigen Entwicklungsumgebungen ist gegeben. Das Deployment erfolgt teilweise in sogenannte Slots, die innerhalb von Sekunden gewechselt werden können und somit ein Fail-Back-Szenario für DevOps-Umgebungen bieten.

Der Bereich Identity und Access Management vereint die Bereiche Verzeichnisdienste, Identitätsvalidierung und rollenbasierte Berechtigungsvergabe. Um keine Abhängigkeiten vom Cloud-Anbieter zu erhalten, sollte die Validierung der Identitäten mit einem externen Dienst realisiert werden, welcher den Einsatz von mehreren Cloud-Umgebungen unterstützt. So können z.B. Office 365, AWS EC2 Instanzen und Google-Apps Instanzen mit einem organisationsweiten und einheitlichen Authentifizierungsverfahren versehen und abgesichert werden.

Der Datenaustausch und die Ablage sollten immer verschlüsselt erfolgen. Für letzteres bieten Cloud-Anbieter einen sogenannten Key Management Service an. Dieser ermöglicht die Verwaltung des Schlüsselmaterials. Die Verschlüsslung ist meist out-of-the-box aktiv. Jedoch obliegt die Hoheit über das Schlüsselmanagement standardmäßig dem Anbieter. Die Absicherung erfolgt durch Hardware-Security-Module (kurz HSM), welche dem FIPS 140-2 entsprechen sollten. Für sensible Daten, z.B. solche, die gesetzlichen Regularien – wie der EU-DSGVO oder dem Bundesdatenschutz – unterliegen, ist dies jedoch ein unzureichender Schutz. Hier sollte das Schlüsselmanagement dem Kunden obliegen, dafür werden eigene HSMs benötigt. Um Daten nachweislich zu löschen, kann dann der entsprechende Krypto-Key vernichtet werden. In Abhängigkeit vom gewählten Kryptoverfahren sind die Daten vor jeglichem Zugriff geschützt und eine höhere Bindung an den Anbieter wird vermieden.

Der Bereich Backup- und Desaster-Recovery bietet die Möglichkeit, Daten außerhalb des Unternehmens zu lagern. Abhängig von der Datenmenge und der Anbindung des Unternehmens, ist ein reiches Backup jedoch meist nicht ausreichend, da die Wiederherstellung der Daten am Unternehmensstandort aufgrund des Volumens meist zeitlich nicht vertretbar ist. Somit sollte immer auch die Möglichkeit eines Desaster-Recovery in der Cloud betrachtet werden, da hier viele Stolpersteine lauern. Zum Beispiel Inkompatibilitäten der virtuellen Maschinen zur Cloud-Umgebung.

Für die Einführung von Cloud-Services empfiehlt SHD folgendes Vorgehensmodell:

Im Grobkonzept sollten ferner folgende Punkte bereits abgedeckt werden:

- Anwendungsfälle

- zu erwartendes Kommunikationsverhalten u. Auswirkungen auf die Organisations-IT

- Vorschriften und Schutz der Daten

- zu erwartende Kosten

- Benutzerakzeptanz

- Exit-Strategie, z.B. bei Problemen mit dem Cloud-Dienst

Insbesondere die Exit-Strategie wird von vielen Organisation gern vernachlässigt. Ändert der Cloud- Anbieter jedoch den Funktionsumfang der Plattform oder stellt dieser den Betrieb ein, ist eine Exit- Strategie essentiell. Meist werden derartige Änderungen kurzfristig bekannt gegeben und erfordern ein schnelles Handeln. Dies hat zum Beispiel der Fall von Nirvanix 2013 gezeigt hat.

Sie wünschen eine umfassende Beratung zu Ihrer Cloud-Strategie? Kontaktieren Sie uns!

Weiterführende Informationen:

Cloud & Backup Strategien von SHD

Bildquelle/Copyright: © Designed by macrovector / Freepik + 5°sued